Deep fake – технология глубокой лжи

Фото: открытый источник Яндекс-картинки

В прошлой нашей статье мы поговорили о фейках. Но они развиваются – трендом 2019 года стала технология deep fake. Что это такое, как используется и к чему может привести? Поразмышляем об этом.

Слово deepfake появилось в 2017 году, соединив в себе понятия глубокого обучения – deep learning, и подделки – fake.

Алгоритмы дипфейков позволяют создавать видео, на которых показано то, чего реальный человек никогда не совершал. Например – речь «Обамы» про Трампа, созданная в 2018 году и в исходной версии набравшая 7 млн. просмотров, которой многие поверили.

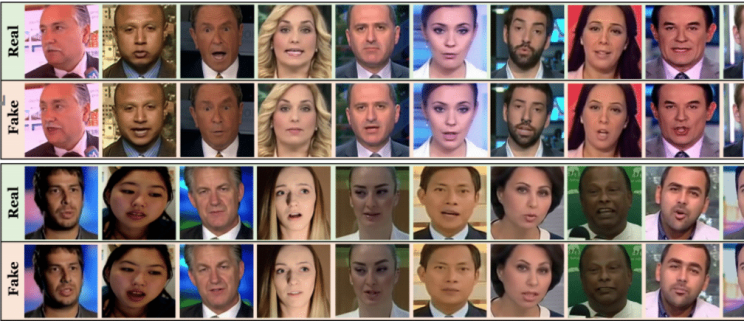

Технология deepfake использует генеративно-состязательные сети (GAN) – программу, способную создавать из существующих наборов данных новые, синтезируя человеческие изображения. Сам «алгоритм объединяет несколько фото, на которых человек изображён с разным выражением лица, и делает из них видео».

Программа обучается сама на основе материалов, доступных в сети. Это уже привело к нескольким крупным скандалам.

Часто мы слышим фразу – «спроси у Гугла» или «спроси Алису». Многие уверены в том, что поисковики знают всё. Но что если искусственный интеллект, на базе которого работает поиск, вместе с недобросовестными людьми и становится источником фейков? Жизнь показала – искусственный интеллект легко распространяет ложь! Ведь он не имеет человеческих критериев оценки правды и лжи, он исходит из наличия доступной информации.

Последствия «глубокой лжи» могут быть намного страшней, чем подпорченная репутация известного актёра или политика.

Фото: открытый источник Яндекс-картинки

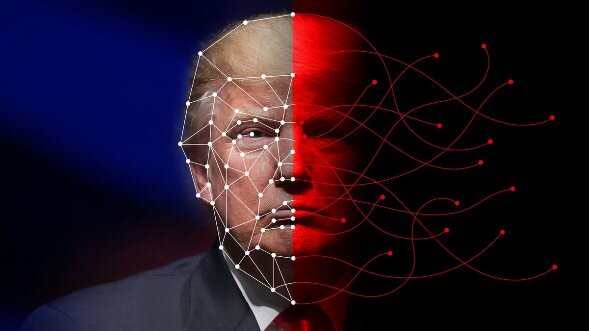

Сегодня deepfake позволяет влиять на общество, а завтра может стать угрозой национальной безопасности, ведь «со временем дипфейки будут становиться всё более реалистичными». Это может быть видео с объявлением войны или взятием ответственности на себя в каком-то теракте. Как же бороться с этим?

В октябре 2019 года Калифорния стала вторым штатом в США, где ввели уголовную ответственность за распространение дипфейков в политических кампаниях и рекламе. Аналогичный закон принял и Китай.

Фото: открытый источник Яндекс-картинки

Но у технологии есть активное лобби – её поддерживают кинематографисты, не раз использовавшие образ умерших актеров в новых фильмах. Полностью запретить deep fake проблематично – многие считают это ограничением свободы слова, а найти лазейки в сети несложно.

В СМИ обсуждается вопрос – «в чём разница между представлением и реальностью» и как определить «это реальность или дипфейк». Ведь сегодня «факт — не то, что было в реальности, а то, о чём слышала критическая масса потребителей информации». Грань между реальным и виртуальным миром становится всё тоньше, и очень нелегко её заметить.

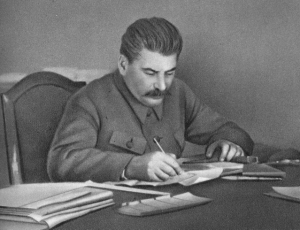

Фото: открытый источник Яндекс-картинки

Где же выход? Как пишут специалисты:

«В мире, где сложно отличить реальное фото или видео от обработанного, единственным ориентиром становится доверие к источнику информации».

Главное – не подменять свой человеческий разум искусственным интеллектом машины.

Роман КОТОВ

2019 г.

P.S. Для освежения памяти можно вспомнить то, что было доступно ТВ прошлого и активно использовалось еще 25 лет тому назад.

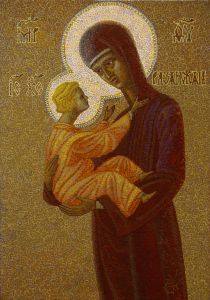

Конкурс "Воскресающая Русь"

Конкурс "Воскресающая Русь"

Дмитрий Юдкин

Дмитрий Юдкин

Иван Жук

Иван Жук

Екатерина Лазарева

Екатерина Лазарева

Павел Турухин

Павел Турухин

Николай Боголюбов

Николай Боголюбов

Вадим Бергаментов

Вадим Бергаментов

Тимофей Крючков

Тимофей Крючков

Олег Зарубин

Олег Зарубин

Евгений Шевцов

Евгений Шевцов

Игорь Горбачев

Игорь Горбачев

Валерий Шамбаров

Валерий Шамбаров

Сергей Рассказов

Сергей Рассказов

Николай Зиновьев

Николай Зиновьев

Владимир Крупин

Владимир Крупин

Марина Хомякова

Марина Хомякова

Павел Рыков

Павел Рыков

Олег Кашицин

Олег Кашицин

Никита Брагин

Никита Брагин

Владимир Хомяков

Владимир Хомяков

Андрей Сошенко

Андрей Сошенко

Сергей Моисеев

Сергей Моисеев

Георгий Боровиков

Георгий Боровиков

Олег Платонов

Олег Платонов

Александр Ананичев

Александр Ананичев

Юрий Кравцов

Юрий Кравцов

Виталий Даренский

Виталий Даренский